A evolução das ferramentas de inteligência artificial tem tornado cada vez mais difícil identificar quando uma imagem ou vídeo é real – ou foi totalmente fabricado por algoritmos.

O avanço dos chamados deepfakes e das imagens geradas por IA já levanta preocupações em áreas como política, jornalismo, entretenimento e segurança digital.

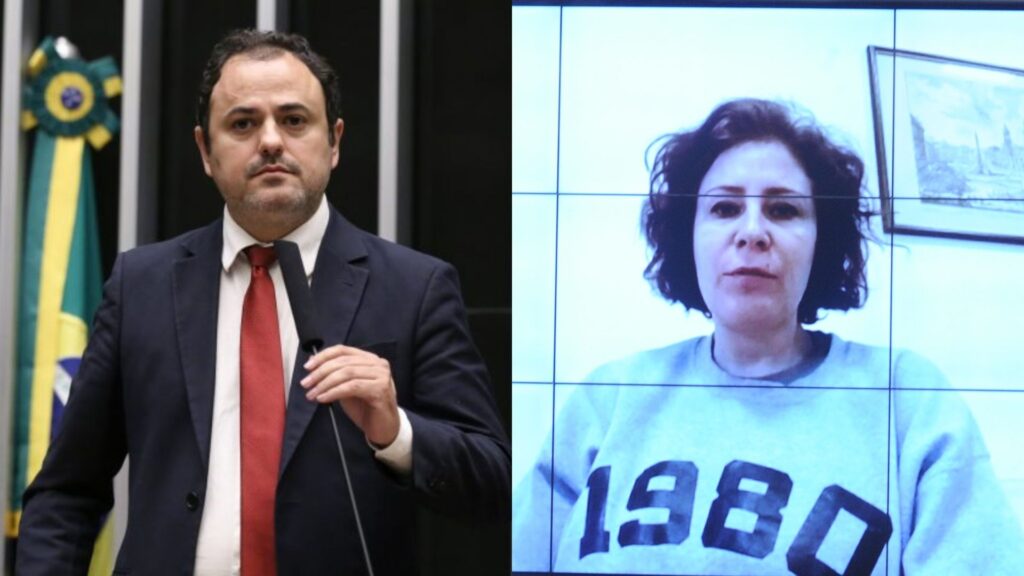

Com a popularização das ferramentas como DALL·E, Midjourney, Sora, Runway e VEO3 – que criam fotos e vídeos hiper-realistas a partir de comandos de texto – o número de conteúdos sintéticos circulando na internet disparou. Quem nunca se deparou, só em junho deste ano, com aqueles memes cansados de entrevistas fakes?

O problema é que nem sempre o público sabe que aquilo que está vendo nunca existiu de fato.

A ilusão

A inteligência artificial generativa é capaz de criar retratos fotorrealistas de pessoas que nunca existiram, simular paisagens, fabricar cenas urbanas e até clonar vozes com uma fidelidade que beira à perfeição.

Um exemplo recente de manipulação, foi o de um vídeo no qual o presidente Luiz Inácio Lula da Silva estaria bêbado na cúpula do G7 no Canadá. O conteúdo, claro, era absolutamente falso.

O desafio é que essas produções, em muitos casos, enganam até especialistas. Um estudo publicado pela revista científica PNAS (Proceedings of the National Academy of Sciences), em 2023, mostrou que pessoas comuns erram em mais da metade das vezes ao tentar identificar rostos reais e falsos. A taxa de acerto ficou em apenas 48%, abaixo do nível de acerto esperado por mero acaso.

Escala global

Como visto no caso de Lula, o uso malicioso de vídeos e fotos geradas por IA não é apenas uma hipótese futura.

Durante as eleições gerais da Eslováquia em 2023, um áudio falso atribuído a um político da oposição influenciou a opinião pública a poucos dias do pleito. Embora tenha sido desmentido, o conteúdo viralizou nas redes antes da checagem.

O Fórum Econômico Mundial, em seu relatório de riscos globais para 2024, listou a desinformação gerada por IA como uma das maiores ameaças à estabilidade social e política nos próximos anos.

Filtros ou manipulação?

Em aplicativos populares como Instagram e TikTok, o uso de IA para alterar rostos, simular maquiagens e mudar fundos de tela já virou prática corriqueira — e muitas vezes nem é percebido pelo público. A linha entre um filtro inofensivo e uma manipulação enganosa torna-se cada vez mais difícil de se identificar.

Plataformas como Meta (Facebook e Instagram) anunciaram medidas para começar a rotular conteúdos gerados por IA a partir de 2024. Segundo a empresa, imagens e vídeos alterados por ferramentas como DALL·E e Midjourney devem receber avisos claros para alertar os usuários.

O TikTok adotou medida semelhante. No entanto, a eficácia da rotulagem depende da colaboração dos criadores de conteúdo — e nem todos cumprem.

Há como identificar?

Apesar dos avanços, ainda existem pistas. Imagens geradas por IA normalmente possuem anomalias sutis, como dedos a mais, proporções corporais estranhas, reflexos inconsistentes ou textos embaralhados. Já em vídeos, o movimento dos olhos, o sincronismo labial e sombras incoerentes podem indicar manipulação.

Pesquisadores trabalham no desenvolvimento de ferramentas de detecção automática. O Google e a OpenAI, por exemplo, estão investindo em mecanismos que permitem rastrear a origem dos conteúdos — como a marcação digital conhecida como watermarking invisível.

A Adobe lançou o projeto Content Credentials, que embute metadados indicando se uma imagem foi gerada por IA. Mas, ainda não há uma solução universal ou padronizada capaz de garantir a identificação precisa de todos os conteúdos.

Regulamentação em debate

Diante dos riscos, a regulação passou a entrar na pauta de governos. A União Europeia aprovou, em 2024, a Lei de Inteligência Artificial, que exige a rotulagem obrigatória de conteúdo sintético, especialmente em contextos políticos, publicitários e jornalísticos. Nos Estados Unidos, projetos semelhantes tramitam no Congresso.

No Brasil, o PL 2.338/2023, que trata da regulamentação da IA, prevê dispositivos sobre transparência, responsabilidade civil e direitos digitais, mas ainda está em fase de tramitação.

Conclusão

Saber se uma imagem ou vídeo foi gerado por inteligência artificial está se tornando uma tarefa cada vez mais complexa.

Em um mundo onde os olhos já não bastam para julgar o que é real, a alfabetização digital, o pensamento crítico e políticas públicas eficazes serão fundamentais para enfrentar os riscos da desinformação intencional.